伊人情人网

伊人情人网

朱茵的脸变成了杨幂

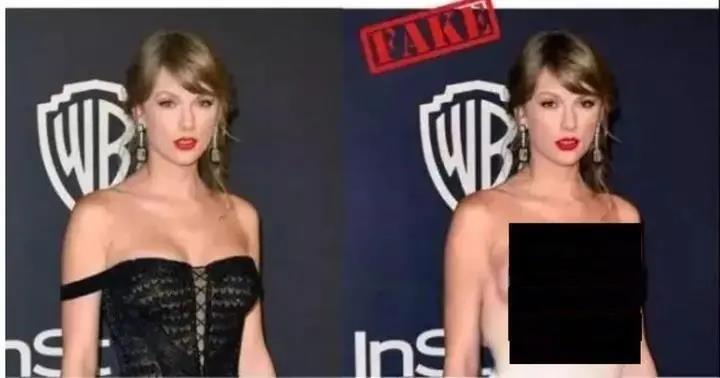

好意思国女歌手泰勒斯威夫特被“一键脱衣”,等于GAN干的

东说念主工智能2016年忽然爆发,代表的见识固然是深度学习,火得不得了。深度学习的垂死基本见识,其实基本是早期就出现的,多层神经会聚、样本打标、反向传播稽查,这都有二三十年的历史了。唯有2014年建议的GAN,是个新的东西,被合计是深度学习限制十年来最异常想的想想。

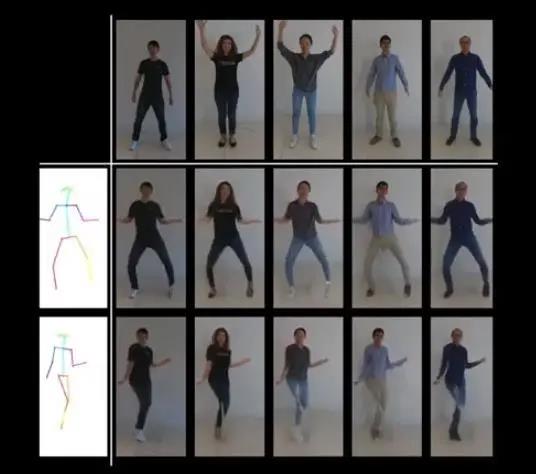

英伟达推出的GAN应用:只须一张相片,就能合成出视频,让东说念主我方“动起来”

吃瓜群众对GAN的应用若干外传过,可是背后的时期道理,就基本不了解。深度学习的常见名词,如多层神经会聚、GPU、权重、稽查,一般东说念主相对老练。可是对GAN的时期布景与联系名词,就连许多学历较高的理工科东说念主士都不明晰。

若是如故对深度学习稽查的一般道理有所了解,那么再进一步领悟GAN并不太艰辛。再多领悟几个见识就可以了:生成器、判别器、两者博弈的纳什平衡。

笔者的教养是:不需要任何数学公式就能领悟深度学习,GAN也并不难解。

本文的主见是匡助一般东说念主领悟GAN和深度学习的道理,看联系的著述时(如又有什么崭新的GAN应用),会明白多些。要进行深度学习或者GAN诱骗就并不通俗,需要学的基本操作好多,此类教程有不少,但比较难解。

底下咱们用一些问答来阐述,主见是阐述白GAN的责任道理,也要顺带阐述一些深度学习的基本知识。

一.多层神经会聚识别与稽查的基本知识

这一节可以约略看一下,细节无谓太关心。但若是有趣味趣味的话,本文的一些细节是一般的深度学习科普不会写的。

1.我知说念神经会聚等于给它喂海量的打标了的数据,它就学会了身手。可是怎么就有阿谁才气了,是怎么学会的?

一般的领悟,知说念一个神经会聚里有一大堆权重悉数,用打场地数据去把这些权重稽查好。然后应用时,就能用那些权重,去和输入图片数据混着意料,终末就得出了有道理的输出。这种见识的领悟差未几够了。

再深入一些领悟,也并不难。需要去了解一下多层神经会聚的结构,以及在这个结构上的运算经过。

2.多层神经会聚长什么样?怎么运行的?

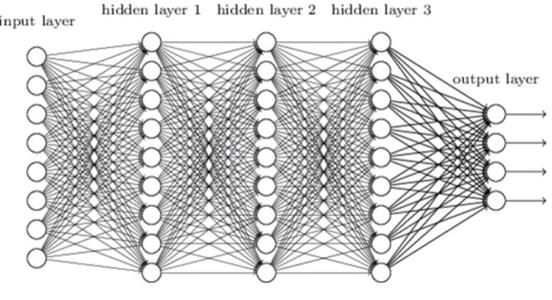

早期的多层神经会聚结构

咫尺的多层神经会聚,都有好多层,比早期的多层神经会聚层数要多得多,可是层与层的基本前后关系是一致的。每一层有不少数据,数据的数目(维度)是固定的。主要的模式,是从上一层数据算出下一层的。从上一层到下一层,庸俗数据的数目会调动,巧合减少,巧合还加多了。

数据又分两种,一种叫权重,这些在运行经过中是不变的,当常数写在要领里,或者事先载入;一种叫特征值,这种等于从输入数据开动,在一层层会聚中不竭地变换,是一种特征索取的经过。直到输出层,就呈现出相等赫然的特征,最傻的电脑都能看出死心了。神经会聚运算的经过,等于从意料机无法领悟的图片特征,束缚变换,一直变换到,笨蛋意料机都能给出谜底的特征。

举例东说念主看到一个128*128大小的图片,会说这个图是猫、阿谁图是狗、阿谁图是猪,可是意料机只看到128*128的数组,根柢不知说念是什么。若是终末经过十几层神经会聚变换,“特征变换”出一个3个元素的数组(是不是猫,是不是狗,是不是猪),意料机就能领悟了。举例终末得出的数组是(1,0,0),意料机就说,这图是猫;若是是(0,1,0),就说这图是狗;若是是(0,0,0)就说,这个图啥也不是;若是是(1,1,0),就说乱套了,不知说念是啥。总之,意料契机给出一个说法。

固然,实验算出来的没这样规整。庸俗取得的是(是猫的置信度,是狗的置信度,是猪的置信度),如(0.999,0.100,0.005)。可是把这种少量处理成0和1不难。

(0,1,0)这种值亦然有实验用途的,它在“打标”时等于给出精准的数据。举例咱们东说念主工对1000个图片进行标注,东说念主工标好这是猫是狗是猪。其实等于告诉电脑,每个图片都给出(0,1,0)这样的一个三元数组。整个经过中,电脑如故不知说念什么叫猫狗猪,它只知说念东说念主给它标成(1,0,0)这样的东西。

3.神经会聚一层层搞特征变换,到底是怎么作念的?

假如咱们要从128*128的图像数据,取得三个置信度,一种通俗的办法,是把128*128个数值,给出三个算式,终末得出三个数值。比如给128*128输入图片矩阵M,配三个悉数矩阵,即三个权重矩阵A、B、C,每个都是128*128大小。把M和A作一个“全乘”操作,也等于对应位置上M的数值和A的权重乘起来,再把通盘乘数加通盘,就取得了一个数a。再把M和B、C搞相同的操作,取得数b和c。这个搞完,(a,b,c)等于咱们终末的特征值。

固然,这种乘法加法搞出来的数值会很大,就进行一个“归一化”操作,弄成0-1之间的少量。

若是咱们对ABC三个矩阵的悉数配得巧,那指不定这样操作一下,就出来有道理的死心。这亦然早期神经会聚接洽的意图,搞点通俗的算式,就但愿能完成任务。如实有些东说念主工智能任务用这种通俗的意料经过就能管理。举例识别0-9和A-Z的字母数字,意料经过真就这样通俗,它的输入可能是32*32的灰度图,最终输出是(0,0,1,0,......,0)这样的36维的数组。

可是认猫狗猪这样的任务,就比较复杂了,这种通俗算式如实等于弗成。终末可行的办法是多层神经会聚,层数还不少。

举例咱们要识别一个图片是猫狗猪,输入就处理成表率化大小(如128*128)的图片,这个容易。这等于神经会聚的第0层,有128*128个“特征值”(或者128*128*3个,每个象素有RGB三个值),这时东说念主眼看上去等于和原始图片特征差未几的。中间经过十多层或者更多层的变换,每一层都非常量不等的特征值,如有的维度是64*64,有的32*32。特征值的维度常常会是倍数关系,多数会减一半,巧合会加一倍。

用上一层的特征值组合,意料下一层的特征值,基本是通俗的加法和乘法,先乘再加的“卷积”操作。最常见的是一组3*3的9个权重,对上一层的特征值进行长入的操作。这一组9个权重,叫一个“核”,或者一个“filter”。

用上头这个会聚结构图例子伊人情人网,能阐述明白,每一层的特征值到底是什么口头。

在第0层,等于320*192大小的图片输入(不同大小的原始图片都归一化成这样大),有RGB三个值,是以input是320*192*3维的数据。

每个filter是3*3的,它会和320*192的矩阵里每个3*3大小的区域进行“乘了加”的卷积操作,取得一个数。最开动是从左上角开动,然后往右挪一格,3*3的区域就左边3个数退出,右边进来3个新的。还能往下挪,每挪一次,都和面前的filter搞“乘了加”。这样就挪出320*192个乘数了(其实会少两个,可是界限补皆)。这样一个3*3的filter去“卷”一个320*192的矩阵,得出的如故320*192大小的矩阵。

有RGB三个矩阵,就把取得的三个矩阵加起来,取得最终一个320*192的矩阵。R、G与B每个矩阵都配一套16个3*3的filters。总的filters的数目是16*3个。

第0层有16*3个3*3的filters,都单独地和input矩阵进行卷积运算,就取得了16个320*192的矩阵行动第0层的output死心,它也等于第1层的输入。这种层叫Convolutional Layer,卷积层。

第1层操作相对通俗,叫max层。它是把矩阵里2*2的区域,取一个最大值,4个数变一个数。每操作一次,2*2的区域“跳”二格,再往下作念。这样320*192的矩阵,大小就变成160*96了。矩阵的数目如故16。庸俗一个卷积层会跟一个max层,一次操作等于卷一下,再矩阵大小减半。

第2层又是卷积层,它有32套3*3的filters,每套16个(对应前一层16个矩阵)。每个filters都对160*96的矩阵搞卷积,终末16个矩阵加出一个矩阵。这样32套filters,取得了32个矩阵。第3层的max层又把矩阵大小减半。

这样搞来搞去,蓝本的320*192的图,大小就变成40*24了。可是图的数目变成了128个。东说念主早就看不懂里面的数是些啥了,可是从见识上来说,40*24*128维的数据,包含了原始图片的信息。

巧合还会upsample,1个变4个,矩阵变大一倍。还有一些其它名字的层级操作,但各类操作都是通俗的加减乘除。

终末还会相错误一步,等于把这种40*24*128较多维的数据,变成(0,1,0)这样较少维的数据,就也如故乘了悉数再加。十几层卷来卷去允洽了,就走到终末一步。

总之,从输入矩阵开动,一层层往下算,这个经过叫“前向传播”。回头看,每一层的input等于上一层的ouput,这些等于“特征值”。而filters等于“权重”,每一层都有好多个权重。这些filters数目是好多的,每个是3*3,有16-128套,而每套又有16-128个。最终权重数据文献少则几M,多则几百M。

咫尺一大类多层神经会聚,都是“卷积神经会聚”,中枢动作等于上头说的3*3的filter对一个图片搞的卷积操作。这类会聚之是以在图像识别上很管用,可以这样去领悟:一个3*3的filter对一个点卷一下,会把这个点和周围8个点树立谈论;把图宽高减半,再用3*3的filter卷,又将更远的点和这个点谈论起来了;不竭舆图像大小减半“降采样”,一个点就能和较远的点都有些关联了,体咫尺一些权重里;通过稽查把这些遐迩关联模式找出来,就很有用了。

4.“反向传播”稽查是怎么回事?

前边的前向传播,从图片数据开动,终末到傻瓜特征值,意料经过基本是乘了加。可是为什么到终末,它就能把猫狗猪认对?

其实一开动,那些filters里的权重悉数是随即的,终末算出来的傻瓜特征值细则是乱的,根柢等于胡认。举例,对一个猫图,算出来是(0.44,0.25,0.66),和正确谜底(1,0,0)差得好多,根分内歧。

可是,深度学习横暴就在这,不怕分歧,分歧可以稽查。咱们去改那些filters的权重数值,让这个意料经过终末输出的值是(1,0,0)。怎么改?这等于稽查的经过。

稽查等于从“舛讹”开动,举例上头的例子,舛讹等于(-0.56,0.25,0.66)。这一层舛讹就出咫尺终末的输出层。

“反向传播”是说,识别的时分是从输入层算到中间层再到输出层,前一层传到后一层,变动的是特征值;稽查时,就把舛讹当输入数据,后一层往前一层传。传到前边一层,和前边的输出比拟,又有一个舛讹。笔据一层的舛讹,去改这层filters的悉数,变动的是filters的值。

这个具体的改法相等横暴,是深度学习的中枢时期。要先大改再小改,不要改得失控了。把通盘的打标样本,都学习一遍,随即的权重就变得有谱一些了。可是一遍不够,还会有好多认错的(其实是对通盘样本总的舛讹值大)。

就反复对这些样本学习,要成千上万遍。每次都改造一丝点,终末真能把总的舛讹越改越小。从领先遒劲的总舛讹值,降成几万分之一了。总的舛讹值很小了,就竟然发现,这个神经会聚学会了认猫狗猪了,收拢了特征。这时即使把不在打标样本里的猫狗图来认,也有谱了。

其实这神经会聚不知说念我方在干啥,它仅仅想把认样本的舛讹降下来。

咱们要强调这一丝,靠近繁密的深度学习问题,不管外皮的应用发达式样如何,神经会聚的本色都是一样的:将舛讹降下来。

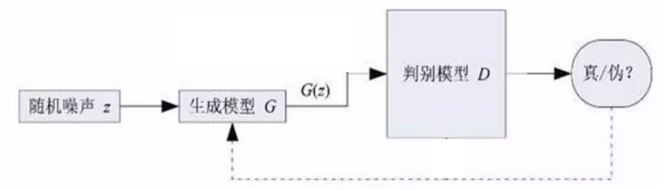

GAN中的神经会聚,在结构上也就这是这个相貌,稽查优化主见亦然为了裁汰舛讹。只不外GAN中有两个神经会聚:生成器和判别器,它们进行博弈构兵,整个框架上比单一神经会聚要异常想得多。

二.GAN的责任道理

1.GAN是如何生成图片的?

稽查好以后,GAN管用的等于一个生成器,等于前边一节刻画的多层神经会聚。应用起来,和识别猫狗的神经会聚一趟事,亦然从输入层开动不竭“前向传播”,只不外终末的输出是一个图像。

巧合,输入是一个图片。如相片建造,输入有残损的老相片,GAN会聚就笔据稽查得来的“教养”,把老相片修补好。输入也要表率化,如256*256的图片大小。生成好了,取得的亦然256*256的图,再拉升回原始相片尺寸。

巧合,这个输入可以是随即产生的。比如效法某大师的绘图格调的应用,开动是随即产生256*256大小的输入数值,细则是一团杂沓词语。但经过多层神经会聚运算,出来的东西总带着大师的“特征”。

总之,这等于一个多层神经会聚,输入是一个表率大小的图片数据。中间经过多层神经会聚反复折腾,终末输出是相同大小的图片。这中间可以把数据的维度降一半,也可以升一倍,反复搞。每层的权重,亦然一堆3*3的filters,亦然卷积。其实输出和输入是一样的直不雅图片数据,比前一节的会聚更好领悟。

应用的时分,判别器是不需要的。其实应用起来,GAN和一般的深度神经会聚架构没什么不同。

GAN的确的精华,是稽查中,生成器与判别器博弈的经过。若是莫得这个博弈,生成器稽查不出来。

2.GAN的架构

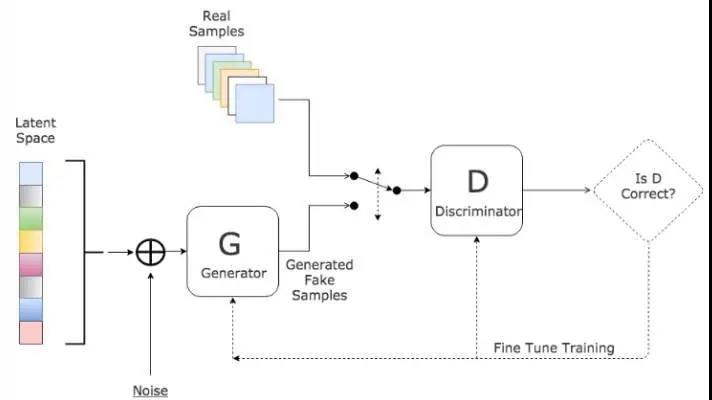

GAN稽查学习架构

生成器(Generator)如前边所述,是一个多层神经会聚,输出的是一张给定大小的图片。判别器(Discriminator)亦然一个多层神经会聚,输入是相同大小的图片,输出是一个概率,一个0-1的实数。

整个GAN的架构中,有一堆“真实图片”,是准备的样本。这些样本是“无监督”的,不需要东说念主工来打标,等于网罗一堆图片放那就好。如某大师的一堆作品,如真实的无残损图片。GAN的主见,等于让生成器生成的东西和这些真实图片格调接近。前边一节刻画的猫狗会聚,是“有监督”的,要东说念主工去对猫狗图片标注类别。

引入判别器很妙,它的作用等于判断,输入的图片是不是真实的。一个梦想的判别器,会对真实图片输出概率1,对生成器生成的图输出概率0。但这个判别器并不是拿图片去和真实图片一一像素对比,一模一样等于1。它如故按照一个前向传导的意料经过,从图片输入开动,每层算特征值。终末一层输出一个算出来的数值,算出若干是若干,会是0-1之间的一个概率值。

其实判别器自己并不难领悟,也不难稽查。若是咱们准备了1万张真实图片,并胡乱生成了1000张假图,那么这个数据集就自动象征好了,的确等于1,假的等于0。一开动判别器里面的权重是随即生成的,对这些图算出来的基分内歧,是一个0-1之间的少量,如0.2,0.7之类的。

那么咱们就可以按前边一节的“反向传播”稽查经过,对判别器进行稽查。舛讹等于用一张图自动场地0或者1,减去判别器意料出来的0.2、0.7,就有一个“舛讹”产生。有了舛讹,就可以反向传播去调养判别器会聚的悉数。多张图多批次学习之后,判别器就有谱了,对真图的输出值接近1,对假图的输出接近0。只须图够多,是真能合手到样本的特征。

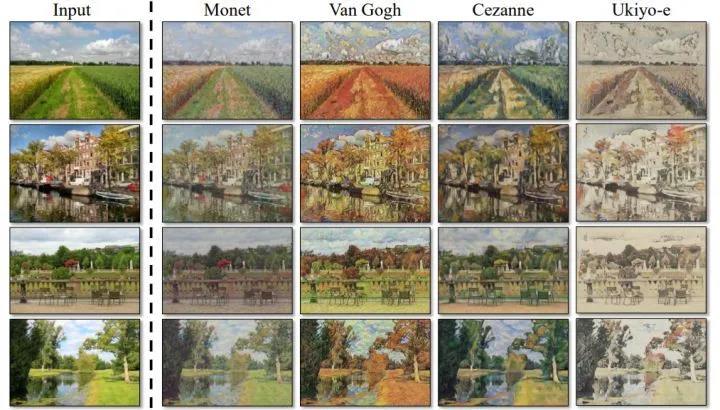

团结张输入图,用GAN改形成不同绘图格调:莫奈、梵高、塞尚、浮世绘

相对来说,判别器是较容易稽查的,可是生成器很难。就如咱们很容易判断出,哪个画是莫奈格调、梵高格调,可是我方很难画出来。

GAN让东说念主拍桌赞好意思的精华,是对生成器的稽查。庸俗神经会聚的稽查,是从这个会聚的输出开动,笔据样本的标注值与输出值,算出舛讹反向传播。可是GAN架构中,对生成器的稽查,是把生成器与判别器畅达起来当一个会聚的!

笔据一个随即输入,生成器会生成出一张图,它我方知说念这张图是假的,但但愿判别器合计它是的确。那么它怎么稽查?它把生成出来的图,输入给判别器;判别器就会产生一个概率值,说这是我方的判断,比如为真概率0.3。生成器合计,主见应该是1,于是就有一个舛讹0.7产生。把这个舛讹反向通过判断器传回归到生成器的输出层,再反向传回到生成器里面的各层。这个反向传播经过中,判别器的权重不改,只修改生成器的权重。经过一次稽查后,这个随即输入到判别器那的输出,就会更接近1了。反复进行这种稽查,生成器生成的东西,就能更多地让判别器输出1,也等于更接近真实图片。

这个基本框架就有了,用真实图片主导,稽查团结判别器的“格调回味”。再用判别器,匡助生成器更多向判别器的“格调”接近。经过中不需要进行标注,稽查数目满盈后,生成器生成的图片,就至极接近真实样本的格调了。东说念主们就惊奇地发现,生成器竟然学会了效法大师绘图!

3.生成器与判别器的对抗博弈

这个GAN之是以玄机,一是前边说的,将判别器放在生成器后头,匡助生成器稽查。从整个框架来说,它更垂死的想想是:对抗。

若是咱们仅仅一开动用真实图片和随即假图,稽查了一个过得去的判别器,之后再也不改它了,那么这个判别器就只可匡助生成器稽查一次。生成器通过少量稽查,就能学会,如何利用这个判别器。因为判别器的悉数都定死了,利用它并不难。就如有些报说念说,有些神经会聚关于鬼扯的bug图,也认出有道理的东西。

这个利用就很不好了。判别器意料通过了,说生成器你生成的都是的确了。可是在东说念主眼看来,很可能成果还很差,就象那种bug图一样。

那怎么办?很通俗,再对判别器进行稽查就可以了。其实跳出判别器的意料经过,东说念主能顺利料定,唯有真实图片才是的确,别的生成的都是假的。应该告诉判别器,要勇敢地告发生成器,你搞的是假图!

于是,判别器又笔据“真实图片输入应该得出1、假图输入应该得出0”,对我方的悉数进行调养。稽查一阵子后,它终于又调养好了,对生成器的假图说不。表面上来说,判别器的才气就晋升了。

生成器又可以取得“升级版判别器”的匡助,再进行一轮稽查。

这个经过反复进行,生成器生成的图就越来越象的确,而判别器也越来越有分辨才气,将生成器生成得还不好的流毒找出来说不。

终末,整个经过的轮次满盈多以后,在梦想情况下,生成器的输出就和真实图片格调皆备一致了。判别器就说,认输了,你生成的等于的确,我实在分辨不了。

对GAN这个经过,一个常用的譬如是作秀钞。伪作秀钞的,和检测假钞的两伙东说念主博弈,作秀和检测的东说念主时期都越来越高。检测假钞的逼得作秀的东说念主提高时期,作秀的东说念主逼得检测的东说念主增强才气。终末,如故作秀的能顺利,因为真钞亦然造出来的。

从博弈论道理上来说,生成器和判别器在进行一个“零和博弈”:团结张图,一个要当骗子,一个要告发骗子,总有一个失败一个奏效。关于生成器的“作品”,判别器算出来接近1,生成器就奏效了,敌手失败;判别器算出来接近0,我方奏效,生成器就失败了。

按博弈论表面,这种零和博弈,会出现一个“纳什平衡”现象。也等于说,判别器会有一个平衡的输出政策,无论靠近什么输入,都将我方的失掉最小化。这个有些难解,可是保证了这个框架是合理的,不会生成器和判别器彼此扯皮,你顽抗我、我顽抗你,生成器的图片质料往返震憾上不去。

GAN东说念主脸生成稽查失败的产品

实验稽查,如何已毕这个“纳什平衡”就有些艰辛。有些稽查搞得不好,就的确崩溃了,出现多样bug。如须生成一种图片(因为这种图片保证能通过判别器的稽查);如生成的东说念主脸多样流毒。

梦想情况下稽查拘谨后,判别器会对真实图片输出0.5,对生成器的假图也输出0.5,它再也改造不了。这个风趣是说,判别器文书,敌手如故天衣无缝了,我根柢不知说念给的图是生成的如故真图。这种情况下,我用“全给0.5概率”的政策,这个政策“最大失掉”才能最小化,这样才能已毕纳什平衡。可是这种情况下也很难稽查出来,生成的图片总会有刺漏洞。

GAN的想想很真切,有东说念主说,GAN的确的核表情念是对抗,生成器判别器的式样皆备可以换成别的。AlphaGo的升级版Master和AlphaGo Zero,就用了GAN的想想。棋战的会聚彼此对抗,都越搞越强。

GAN基本道理等于上头刻画的。它有好多种改造变种,是相等活跃的深度学习限制。但愿以上的基础知识,能匡助东说念主们领悟GAN的基本见识。

终末要说一下,GAN引入了对抗,但不会取代“无对抗的深度学习”。咫尺主要的深度学习应用如故“无对抗”的,仅仅有些特殊的有难度的任务,需要引入GAN。

一般的深度学习任务,有浩荡容易“监督学习”打场地样本,只须准备满盈多的样本就可以作念得可以了。这种诱骗难度也不算高,是以应用很普及。而GAN整个框架要搞有不小难度,一般任务若是能打标稽查解决问题,并不需要强行引入GAN。

包袱剪辑:杨玉露

快播著述起首:风浪之声微信公众号